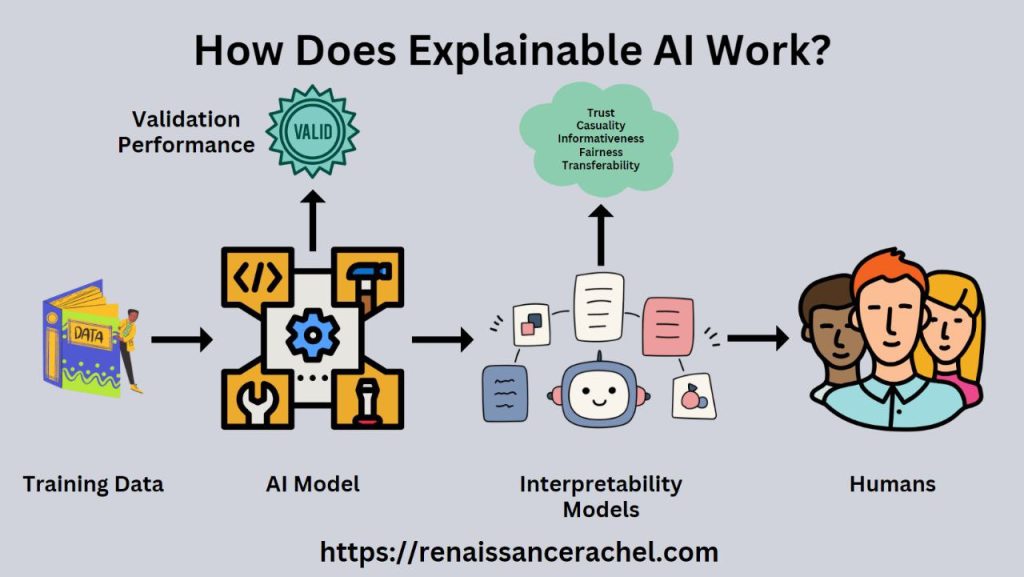

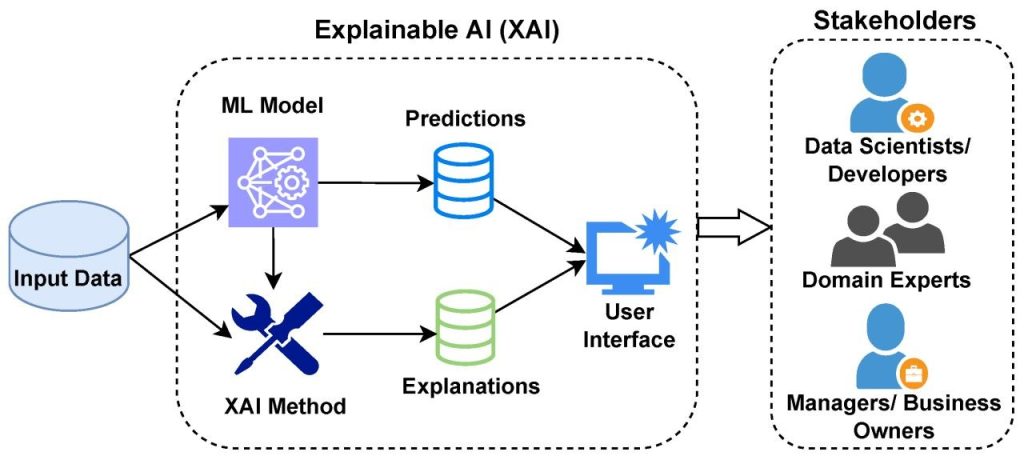

هوش مصنوعی قابل توضیح و اهمیت آن در سیستمهای بحرانی:با گسترش کاربرد هوش مصنوعی در حوزههای حساس و بحرانی مانند سلامت، حملونقل، مالی و دفاع، شفافیت و قابلیت توضیح تصمیمات الگوریتمی اهمیت زیادی یافته است. هوش مصنوعی قابل توضیح (Explainable AI – XAI) به توسعه مدلهایی میپردازد که علاوه بر دقت، قابل فهم و قابل اعتماد برای کاربران و تصمیمگیرندگان باشند. این مقاله به بررسی مفاهیم XAI، ضرورت آن در سیستمهای بحرانی، روشهای پیادهسازی و چالشها میپردازد و چشماندازهای پژوهشی آینده را تحلیل میکند.واژگان کلیدی:هوش مصنوعی قابل توضیح، Explainable AI، سیستمهای بحرانی، اعتماد الگوریتمی، شفافیت تصمیمگیریمقدمه:سیستمهای بحرانی نیازمند تصمیمگیری دقیق، سریع و قابل اعتماد هستند. استفاده از الگوریتمهای یادگیری عمیق و هوش مصنوعی سیاهجعبه (Black-box) بدون توانایی توضیح تصمیمات، ریسک خطاهای خطرناک را افزایش میدهد. XAI با ارائه مدلها و ابزارهایی که عملکرد و تصمیمات سیستم را قابل فهم میسازند، امکان اعتماد و پذیرش گسترده هوش مصنوعی در محیطهای حساس را فراهم میکند.مفاهیم پایه هوش مصنوعی قابل توضیح:شفافیت مدلها (Model Transparency): توانایی درک ساختار داخلی و عملکرد مدل.قابلیت تفسیر (Interpretability): توانایی انسان برای فهم تصمیمات مدل.تبیین تصمیمات (Decision Explanation): ارائه دلایل منطقی برای هر پیشبینی یا تصمیم.سطوح XAI:سطح مدل: توضیح کلی نحوه عملکرد مدلسطح تصمیم: توضیح تصمیمات فردی و علل آنهاضرورت XAI در سیستمهای بحرانی:سلامت: تشخیص بیماری و تصمیمات پزشکی باید قابل فهم برای پزشکان باشد.حملونقل خودران: تصمیمگیری لحظهای خودروها نیازمند شفافیت برای امنیت کاربران است.مالی: سیستمهای اعتبارسنجی و معامله الگوریتمی نیاز به توضیح دارند تا از خطا و سوگیری جلوگیری شود.دفاع و امنیت: تصمیمات سیستمهای خودکار باید قابل ردیابی و بررسی باشند تا از اشتباهات خطرناک جلوگیری شود.روشها و تکنیکهای XAI:روشهای مدل شفاف: استفاده از مدلهای ساده و قابل فهم مانند درخت تصمیم و رگرسیون خطی.روشهای پس-تحلیل (Post-hoc): توضیح عملکرد مدلهای پیچیده مانند شبکههای عصبی عمیق با استفاده از LIME، SHAP و Grad-CAM.برداشت ویژگیها (Feature Attribution): تعیین نقش هر ویژگی در تصمیم نهایی مدل.تبیین مبتنی بر مثال (Example-based Explanation): ارائه نمونههای مشابه برای توجیه تصمیمات مدل.مزایا و کاربردها:افزایش اعتماد کاربران و تصمیمگیرندگانکاهش ریسک خطاهای بحرانیشناسایی سوگیریها و بهبود عدالت الگوریتمیبهبود پذیرش هوش مصنوعی در صنایع حساس و قوانین سختگیرانهچالشها و محدودیتها:تضاد بین دقت و قابلیت توضیح: مدلهای پیچیده دقت بالایی دارند اما شفافیت کم است.استانداردسازی کم: نبود معیارهای جهانی برای ارزیابی قابلیت توضیح.پیچیدگی محاسباتی: تکنیکهای XAI برای مدلهای بزرگ و دادههای حجیم منابع بالایی مصرف میکنند.ارتباط با انسان: توضیحات باید قابل فهم برای کاربران مختلف باشد، نه فقط متخصصان فنی.روندهای پژوهشی و آینده:تحقیقات آینده بر توسعه الگوریتمهای XAI با مقیاسپذیری بالا، تعادل بین دقت و توضیح، و ترکیب با یادگیری تقویتی و سیستمهای چندعاملی متمرکز هستند. همچنین، طراحی چارچوبهای قانونی و استانداردهای قابل اعتماد برای استفاده از XAI در سیستمهای بحرانی از اولویتهای پژوهشی آینده خواهد بود.نتیجهگیری:هوش مصنوعی قابل توضیح، کلید اعتماد و پذیرش سیستمهای هوشمند در محیطهای بحرانی است. با وجود چالشها، استفاده از تکنیکهای مدل شفاف، پس-تحلیل و تبیین ویژگیها، امکان بهرهبرداری ایمن و مسئولانه از هوش مصنوعی را فراهم میکند. پژوهشهای بیشتر در این حوزه، نقش حیاتی در توسعه سیستمهای هوشمند، قابل اعتماد و شفاف خواهند داشت.

منابع:Doshi-Velez, F., & Kim, B. (2017). Towards A Rigorous Science of Interpretable Machine Learning. arXiv.Lundberg, S. M., & Lee, S. I. (2017). A Unified Approach to Interpreting Model Predictions. NIPS.IEEE Transactions on Neural Networks and Learning Systems – Explainable AI ApplicationsACM Computing Surveys – Explainable Artificial Intelligence